LanguageModel

Posted on Word count in article: 300 Reading time ≈ 1 mins.

ML/Deep Learning Note1-杂记

Posted on Word count in article: 1.1k Reading time ≈ 4 mins.

Sequence_Models

Posted on Word count in article: 459 Reading time ≈ 2 mins.

Precision_Recall

Posted on Word count in article: 349 Reading time ≈ 1 mins.

First of all

In machine learing, precision and recall are two standards to evaluate a model , but why precision and recall can make such a useful work? Here are the answers

Rare classification example

When we want to train a classifier to classify the disease on the patient, you train a classifier

If the disease is a rare disease(means it only has 1% possibility to get such a disease) , you may find that you’ve got maybe 1% error on test set(which means 99% correct diagnoses)

Some_Interpretation_About_Resnet

Posted on Word count in article: 283 Reading time ≈ 1 mins.

ResNet

Posted on Edited on Word count in article: 244 Reading time ≈ 1 mins.

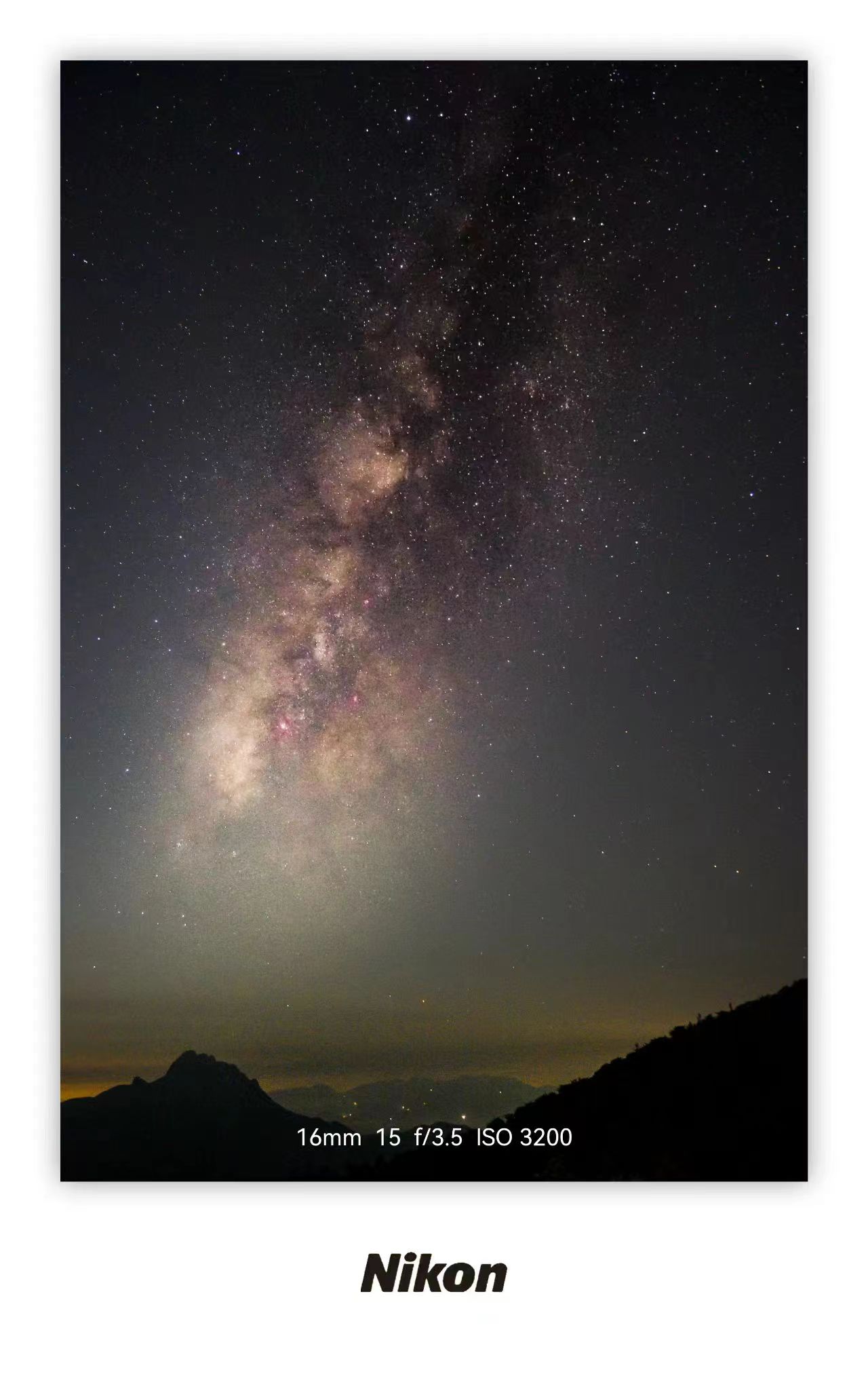

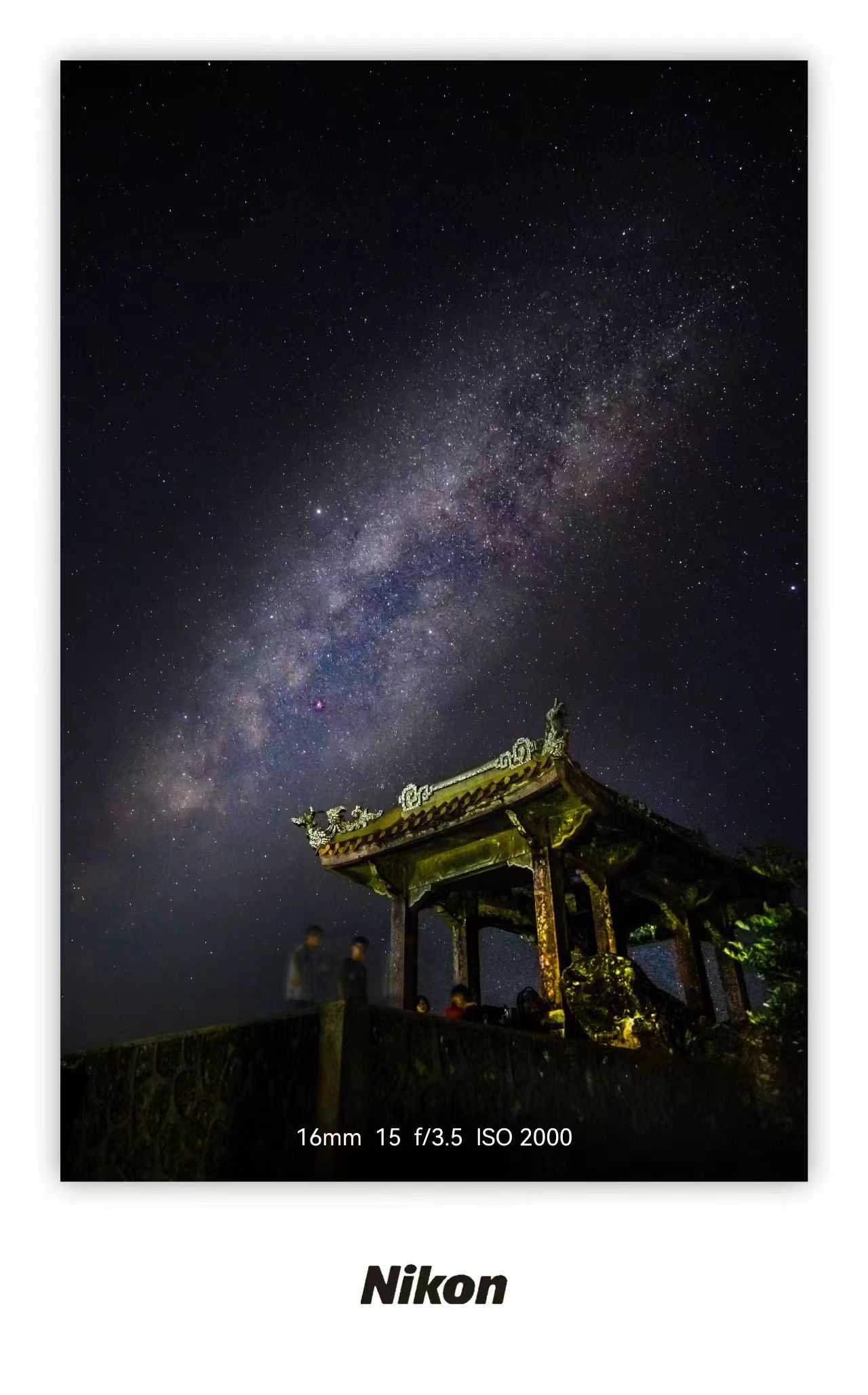

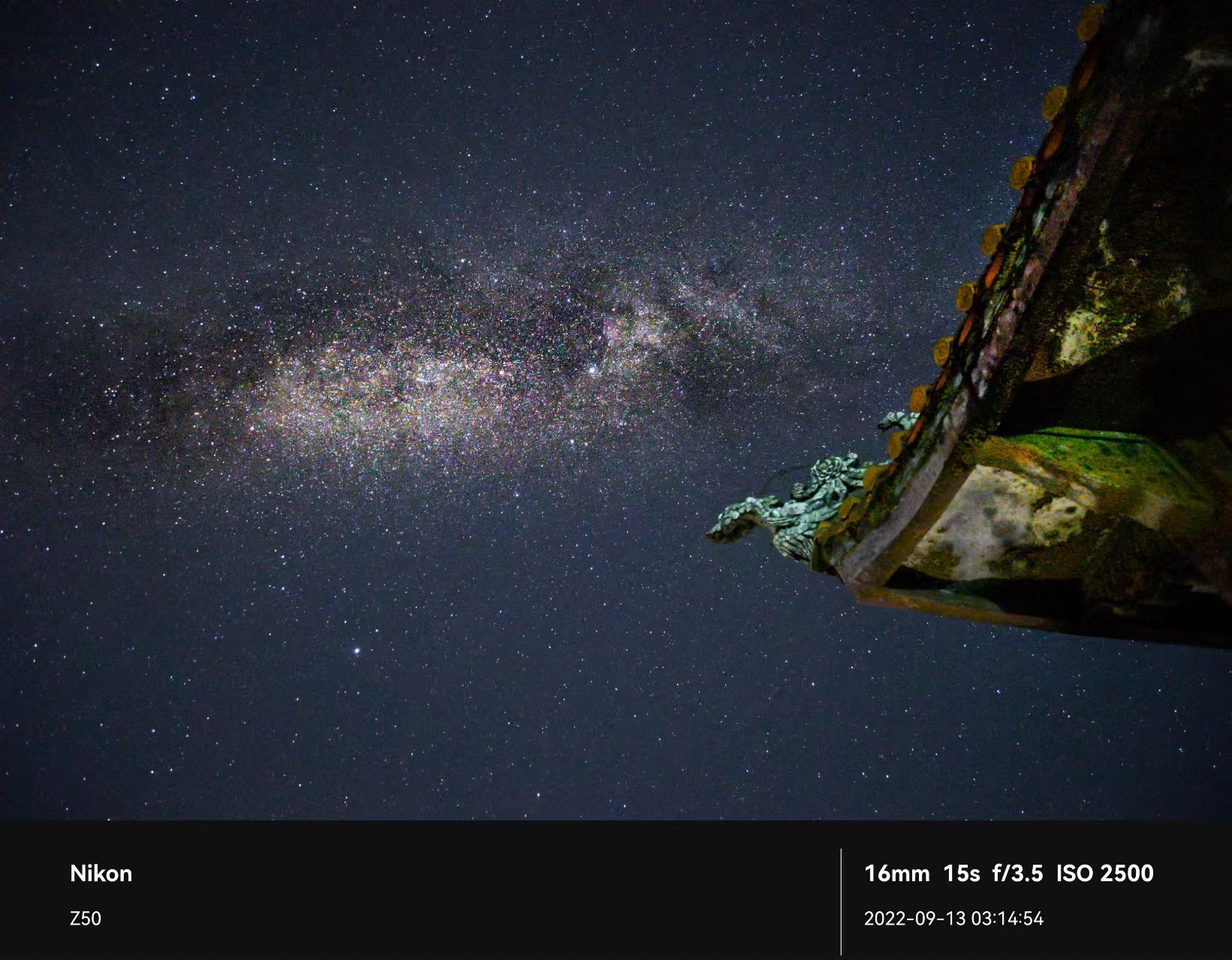

Galaxy of Fenghuang Mount

Posted on Word count in article: 23 Reading time ≈ 1 mins.

Batch Normalization(BN-批量归一化)

Posted on Edited on Word count in article: 738 Reading time ≈ 3 mins.

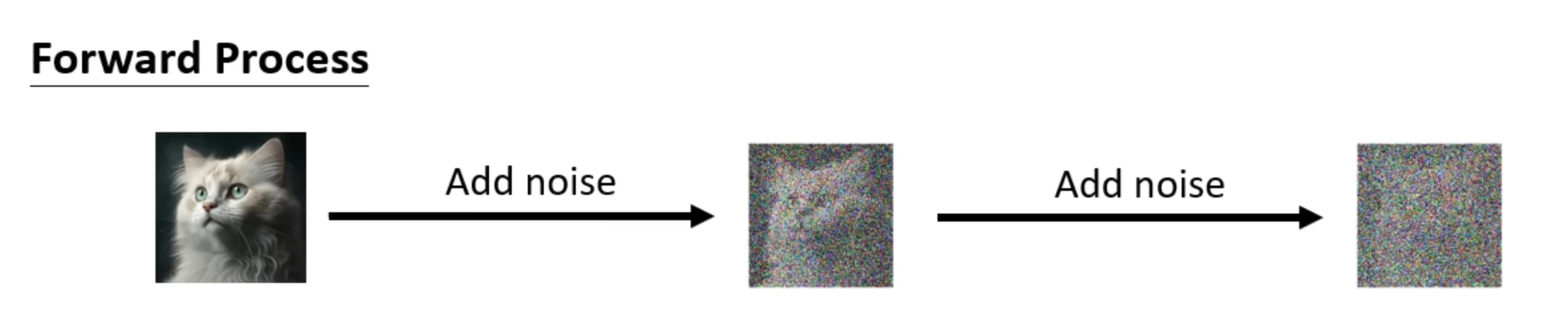

DiffusionModel

Posted on Word count in article: 452 Reading time ≈ 2 mins.